【阅读时间】20min 4589 words

【内容简介】从

【直观理解】线性代数的本质

笔记出发,继续讨论几个线性代数中的概念,正交,正规,正定及转置的直观解释。旨在能帮助读者在看完后不会忘记什么是正交矩阵,什么是正规矩阵,转置部分进行了深入挖掘,希望找出一些几何直观的解释

在之前的

【直观理解】线性代数的本质

的笔记中,详细讨论了

特征值与特征向量的几何直观意义

起初,研究线性代数,也是因为深入了解矩阵(变换)对机器学习中的很多

优美公式的推导和理解

有帮助。上篇笔记中,3B1B团队的讲解内容中没有涉及几个线性代数中的概念,且这些概念在做矩阵分解时会被用到。以

上一篇笔记中的直观理解为基础

(矩阵 = 变换)在这里做一个整理和记录

特征值和特征向量

这篇笔记中的内容,我们知道特征值是对一个变换(矩阵)特性的

有力表征

,公式 $\mathbf A \mathbf{\vec v} = \lambda \mathbf{\vec v}$ 表示了

变换中被留在张成空间内的向量就是特征向量

的符号表达,其中 $\vec v$ 是特征向量,$\lambda$ 即特征值

我们对上式进行一些数学恒等变换,左乘 $\vec v^T$,得到

\vec v^T \mathbf A \vec v = \vec v^T \lambda \vec v = \lambda \vec v^T \vec v \tag{2-1}

此时我们会发现一些巧合,先来看看正定矩阵的正规定义:若一个

n×n

的矩阵 $\mathbf M$ 是

正定的

,当且仅当队友所有的非零实系数的向量 $\vec v$,都有 $\vec v^T \mathbf M \vec v > 0$

我们暂时不考虑复数情况(在机器学习预见复数域的内容较少),结合上面的二公式,发现保证 $\vec v^T \mathbf M \vec v > 0$ 即使得 $\lambda \vec v^T \vec v>0$,其中 $\vec v^T \vec v$一定大于等于0(由于 $\vec v$ 是一个

1×n

的向量,转置进行矩阵相乘实际效果

计算元素的平方和

),所以可以推出即

正定矩阵就是使得特征值大于0

再回到正定矩阵的定义公式 $\vec x^T \mathbf M \vec x > 0$,我们已经有深刻的理解 $\mathbf M \vec x$ 表示对向量 $\vec x$ 进行

变换

,记变换后的向量为 $\vec y = \mathbf M \vec x$ ,则我们可以把正定矩阵的公式写成

\vec x^T \vec y > 0 \tag{2-2}

这个公式是不是很熟悉呢?它是

两个向量的内积

,对于内积,有公式:

\cos(\theta) = \frac{\vec x^T \vec y}{\Vert \vec x \Vert * \Vert \vec y \Vert} \hat {\jmath}

$\Vert \vec x \Vert \; \Vert \vec y \Vert$ 表示 $\vec x$ 和 $\vec y$的长度,$\theta$ 是它们之间的夹角。根据2-2式,可以得到 $\cos(\theta) > 0$,即它们之间的夹角

小于90度

总结:如果说一个矩阵正定,则表示,一个向量

经过此矩阵变换后的向量

与原向量

夹角小于90度

当然,加一个【半】字,是指这个小于变成

小于等于

3b1b的方法

)来理解转置相当困难。此时,需要考虑换一种思考角度,

性质

和

数学计算

(这可能也是解决一个数学问题最常用的两种手段,性质寻找共性,并推广演绎,数学计算导出同样问题的不同表现形式,并总结规律)

特征分解

,则有

AA^{T} = R_{AA^{T}} \Lambda_{AA^{T}} (R^{-1})_{AA^{T}} \tag{14}

之后左乘(这里补充一下,所有的左乘操作在几何意义上来说,就是附加了一个新的变换)$A^{-1}$,得到

A^{T} = A^{-1} R_{AA^{T}} \Lambda_{AA^{T}} (R^{-1})_{AA^{T}} \tag{15}

根据之前(1)式的例子进行计算,发现 $R_{AA^{T}} = (R^{-1})_{AA^{T}}$,并且 $R_{AA^T}$ 首先将空间关于 y 轴对称,之后旋转 $\alpha$ 角度,所以假设定义

R_{AA^{T}}^{'} = \begin{bmatrix}

cos \alpha & -sin \alpha \\

sin \alpha & cos \alpha \\

\end{bmatrix} \tag{16}

利用上面的推导,带入(15)式,得到:

A^{T}=A^{-1}

R_{AA^{T}}^{'}

\begin{bmatrix}

-1 & 0 \\

0 & 1 \\

\end{bmatrix}

\Lambda_{AA^{T}}

R_{AA^{T}}^{'}

\begin{bmatrix}

-1 & 0 \\

0 & 1 \\

\end{bmatrix} \tag{17}

用更加清晰的符号改写(17)式得到

A^{T}=A^{-1} R_{\alpha} M_y \Lambda R_{\alpha} M_y \tag{18}

$M_y$ 表示的是关于y轴对称

$R_\alpha$ 表示逆时针旋转 $\alpha$ 度

$\Lambda$ 表示一种伸缩变换

这里的(18式)结论和

上面的作图规律

,还有(12)式从某种程度上来说有相似的地方

其实应该从矩阵分解的部分来再次思索矩阵转置的意义,可详见

什么是PCA,SVD

最终感觉关于转置还是研究的不够透彻,可能需要拔高到另一个层面去理解会更加直观,但是限于水平,只能至此(并不是数学专业的学生)

$\mathbf A \mathbf A^T$ 的对称特性非常有用

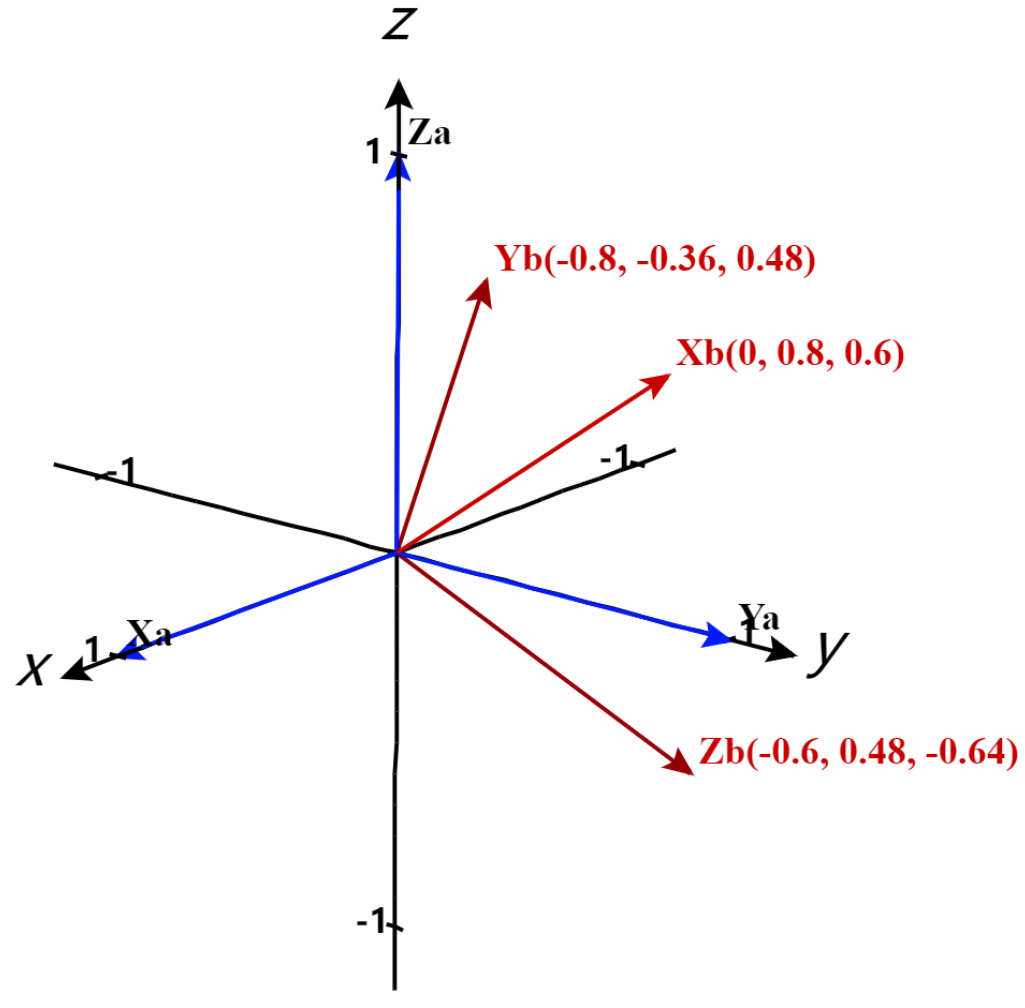

正交 = 旋转 = 垂直,并且

逆等于转置

正规矩阵的定义和转置息息相关,但是从形式上来看,约束条件是逐步变弱的,其实这些特征都是描述了空间一个变换的一些变化模式,比如旋转,伸缩的特殊模式,只需要有一个基本的直观理解,在机器学习领域就已经足够用了